E a Microsoft foi processada por causa do GitHub Copilot, em uma grave violação dos termos das licenças de código aberto.

O GitHub Copilot, lançado em junho de 2022, é um auxílio de programação baseado em IA que usa o OpenAI Codex para gerar código-fonte em tempo real e recomendações de funções no Visual Studio.

A ferramenta foi treinada com aprendizado de máquina usando bilhões de linhas de código de repositórios públicos e pode transformar linguagem natural em trechos de código em dezenas de linguagens de programação.

Agora, o programador e advogado Matthew Butterick processou a Microsoft, GitHub e OpenAI, alegando que o Copilot do GitHub viola os termos das licenças de código aberto e infringe os direitos dos programadores.

Microsoft foi processada por causa do GitHub Copilot

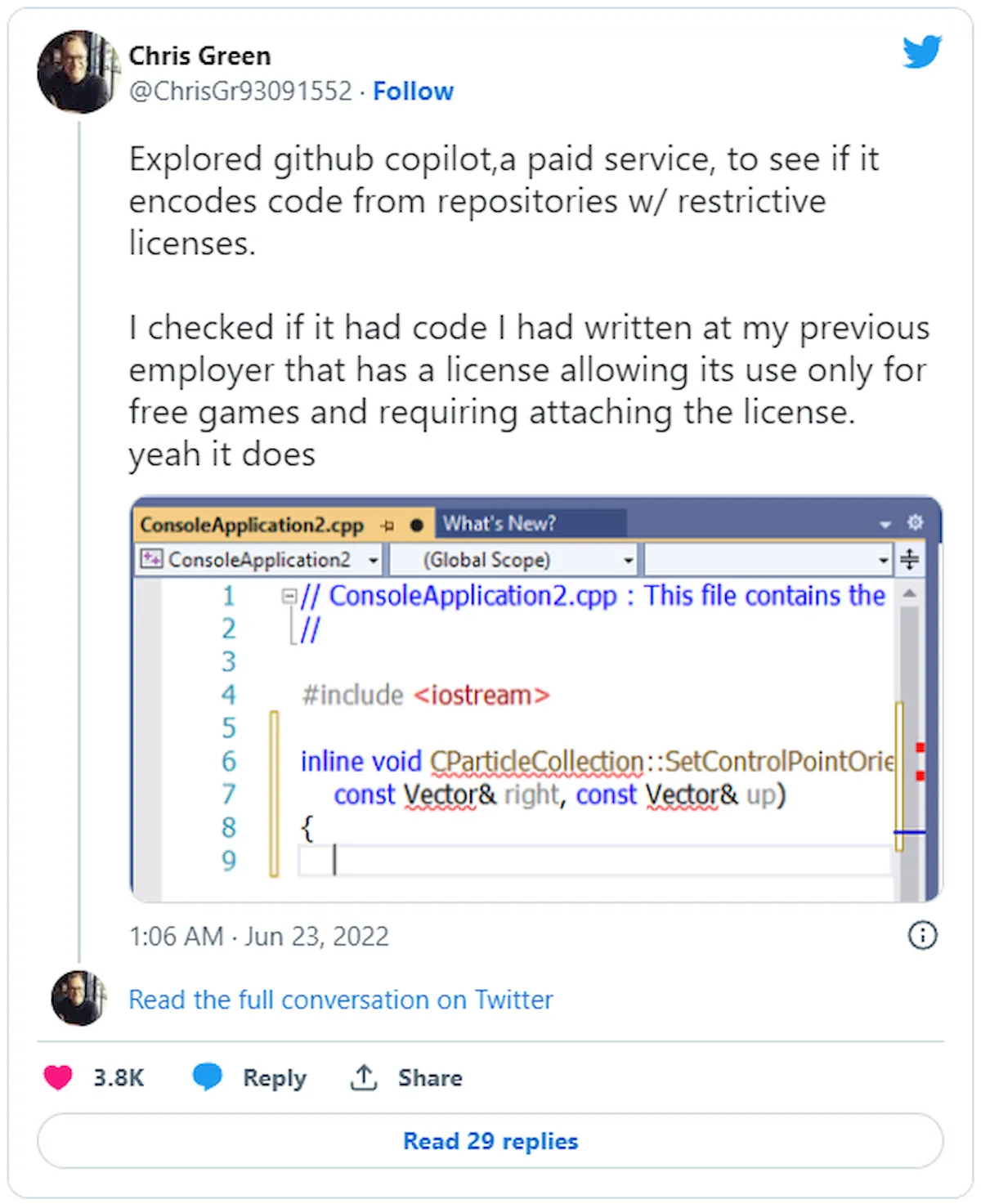

Embora o Copilot possa acelerar o processo de escrita de código e facilitar o desenvolvimento de software, seu uso de código aberto público fez com que os especialistas se preocupassem com a violação das atribuições e limitações de licenciamento.

As licenças de código aberto, como as licenças GPL, Apache e MIT, exigem a atribuição do nome do autor e a definição de direitos autorais específicos.

No entanto, o Copilot está removendo esse componente e, mesmo quando os snippets têm mais de 150 caracteres e são retirados diretamente do conjunto de treinamento, nenhuma atribuição é fornecida.

Alguns programadores chegaram a chamar isso de lavagem de código aberto, e as implicações legais dessa abordagem foram demonstradas após o lançamento da ferramenta de IA.

“Parece que a Microsoft está lucrando com o trabalho de outros ao desconsiderar as condições das licenças de código aberto subjacentes e outros requisitos legais”, comenta Joseph Saveri, o escritório de advocacia que representa Butterick no litígio.

Para piorar a situação, as pessoas relataram casos de vazamento de segredos do Copilot publicados em repositórios públicos por engano e, portanto, incluídos no conjunto de treinamento, como chaves de API.

Além das violações de licença, Butterick também alega que o recurso de desenvolvimento viola o seguinte:

- Termos de serviço e políticas de privacidade do GitHub,

- DMCA 1202, que proíbe a remoção de informações de gerenciamento de direitos autorais,

- a Lei de Privacidade do Consumidor da Califórnia,

- e outras leis que deram origem às reivindicações legais relacionadas.

A queixa foi submetida ao Tribunal Distrital dos EUA do Distrito Norte da Califórnia, exigindo a aprovação de danos legais de US$ 9.000.000.000.

“Cada vez que o Copilot fornece uma Saída ilegal, ele viola a Seção 1202 três vezes (distribuindo os Materiais Licenciados sem: (1) atribuição, (2) aviso de direitos autorais e (3) Termos de Licença)”, diz a reclamação.

“Portanto, se cada usuário receber apenas uma saída que viole a Seção 1202 ao longo do tempo usando o Copilot (até quinze meses para os primeiros adotantes), o GitHub e o OpenAI violaram a DMCA 3.600.000 vezes. Com danos legais mínimos de US$ 2.500 por violação, que se traduz em $ 9.000.000.000.”

Butterick também tocou em outro assunto em um post no blog no início de outubro, discutindo os danos que o Copilot poderia trazer para as comunidades de código aberto.

O programador argumentou que o incentivo para contribuições e colaboração de código aberto é essencialmente removido oferecendo trechos de código às pessoas e nunca dizendo a elas quem criou o código que estão usando.

“A Microsoft está criando um novo jardim murado que inibirá os programadores de descobrir comunidades tradicionais de código aberto”, escreve Butterick.

“Com o tempo, esse processo deixará essas comunidades de fome. A atenção e o envolvimento do usuário serão desviados […] dos próprios projetos de código aberto – longe de seus repositórios de origem, seus rastreadores de problemas, suas listas de discussão, seus fóruns de discussão.”

Butterick teme que, com tempo suficiente, o Copilot faça com que as comunidades de código aberto diminuam e, por extensão, a qualidade do código nos dados de treinamento diminua.

O site BleepingComputer entrou em contato com a Microsoft e o GitHub para um comentário sobre o que foi dito acima e recebeu a seguinte declaração do GitHub.

“Estamos comprometidos em inovar com responsabilidade com o Copilot desde o início e continuaremos a desenvolver o produto para melhor atender os desenvolvedores em todo o mundo.”